知识图谱在人工智能的许多领域都发挥了重要作用,综述论文的这一章引入多个最新的基于深度学习的知识驱动方法,主要包括的应用领域有自然语言理解,推荐系统和问答系统。

1 自然语言理解

知识感知的自然语言理解通过将结构化的知识注入一个统一的语义空间中来提高语言表示能力。最新的知识驱动方法将显式的事实知识和隐式的语言表示用于许多自然语言理解任务中。Chen等人[1] 提出了在两个知识图谱上的双图随机游走方法,这两个知识图谱是基于槽的语义知识图谱和基于词的词汇知识图谱,以考虑口语理解中的内部槽关系。Wang等人 [2] 利用加权的词-概念嵌入表示,以基于知识的概念化策略增强了短文本表示学习性能。Peng等人[3] 集成了外部知识库,以建立用于短社交文本中事件分类的异构信息图谱。

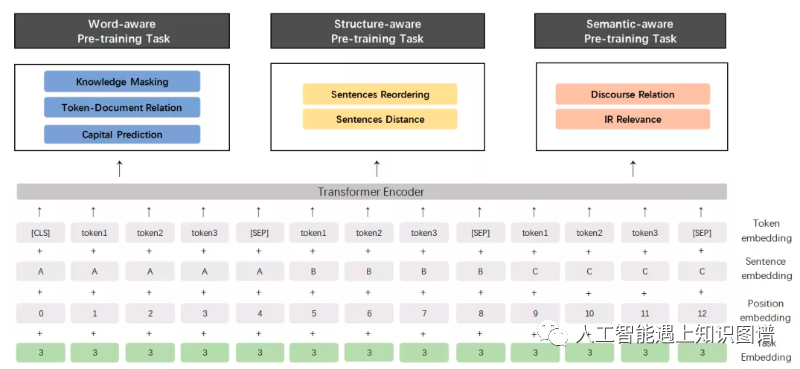

语言建模作为基本的NLP任务,需要预测给定的一段文本序列的下一个单词。传统语言建模没有利用文本语料库中经常观察到的实体信息来引入事实知识。如何将知识融入到语言表示中已引起越来越多的关注。知识图谱语言模型(KGLM)[4] 通过选择和复制实体来学习知识。ERNIE-Tsinghua [5] 通过结合预训练和随机masking来融合有价值的实体。BERT-MK [6] 编码图谱的上下文知识,并专注于医疗语料库。ERNIEBaidu[7] 引入了命名实体masking和短语masking机制以将知识集成到语言模型中,并进一步通过持续的多任务学习改进为ERNIE 2.0 [8]。重新思考语言模型的大规模训练和知识图谱的检索,Petroni等人[9] 对语言模型和知识库进行了分析,发现某些事实知识可以通过预训练语言模型得到。

![]()

2 问答系统

问答系统应该是知识图谱主要的应用场景之一。基于知识图谱的问答(KGQA)是用知识图谱中的事实来回答自然语言问题。基于神经网络的KGQA方法在分布式语义空间中表示问题和答案,有些方法还将符号知识注入以进行常识推理。KGQA方法分为单一事实问答和多步推理问答。

2.1 单一事实问答

单一事实问答是以知识图谱为外部信息源,面向通过单个知识图谱中的事实就可以回答的简单问题。Bordes等人[10] 利用记忆网络将知识库作为外部记忆用于简单的问答。Dai等人[11] 提出了一种带有注意力剪枝的条件注意力神经网络,以减少搜索空间。为了以人们更能理解的方式生成自然语言答案,COREAQ[12] 引入了复制和检索机制,以seq2seq的方式生成平滑自然的回答,这里,从给定问题中复制或从知识图谱中检索得到语料库词汇,并从中预测出答案。BAMnet[13]采用双向注意机制对问题和知识图谱之间的双向交互进行建模。

虽然深度学习技术在KGQA中得到了广泛的应用,但它们不可避免地增加了模型的复杂性。Mohammed等人[14]通过对有无神经网络的简单KGQA模型进行评估,发现复杂的深度学习模型,如LSTM和带有启发式的门控递归单元(GRU),达到了最先进的水平,非神经模型也取得了相当好的性能。

2.2 多跳推理

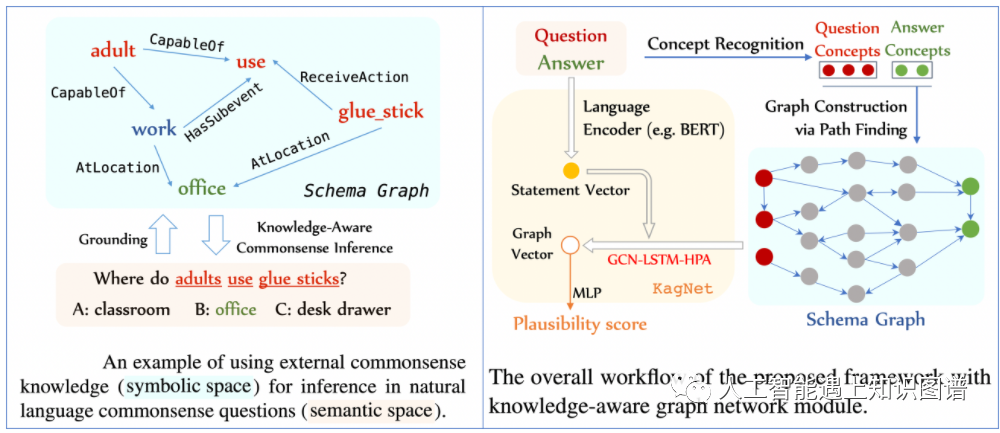

这些基于神经网络的方法通过与神经编解码模型的结合得到了改进,但要处理复杂的多跳关系需要更特殊的设计才能进行多跳常识推理。结构化知识提供了丰富的常识信息,并充当了关系归纳偏差,这推动了近年来在符号空间和语义空间之间进行常识知识融合的多跳推理研究。Bauer等人[15] 提出了双向注意力和指针生成解码器,用于有效的多跳推理和答案生成,其中外部常识知识通过ConceptNet中对关系路径进行选择得到。变分推理网络(VRN)[16] 通过reasoning-graph嵌入技术进行多跳逻辑推理,同时能够解决主题实体识别中的不确定性问题。KagNet[17] 从ConceptNet中构建模式子图,并通过GCN、LSTM和基于层次路径的注意力机制来学习基于路径的关系表示。CogQA[18] 将隐式抽取和显式推理相结合,提出了一种基于BERT和GNN的多跳QA认知图谱模型。

![]()

3 推荐系统

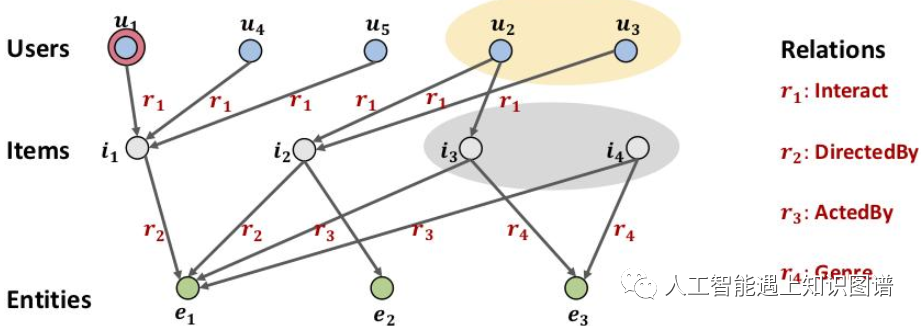

知识图谱的另一个重要应用就是推荐系统。传统的推荐系统主要是利用用户的历史信息进行协同过滤的方法。然而,这类方法往往无法解决稀疏性问题和冷启动问题。将知识图谱作为外部信息进行集成,使推荐系统具有常识推理的能力。通过注入知识图谱中的实体、关系和属性,许多工作致力于利用基于嵌入的正则化来改进推荐系统。协同CKE[19] 通过基于翻译思想的KGE模型(如TransE)和堆叠的自编码器来联合训练KGE、item的文本信息和视觉内容。MKR[20]通过特征共享和建模高阶项目-实体关联,将多任务知识图谱表示和推荐联系起来。KPRN[21] 将用户和项目之间的交互视为知识图谱中的实体-关系路径,并使用LSTM对该路径进行偏好推断,以捕捉顺序依赖性。PGPR[22] 在基于知识图谱的用户-项目交互上执行强化学习策略引导的路径推理。KGAT [23] 将图注意力网络应用于实体-关系图谱和用户-项目图谱的协同知识图谱上,以通过嵌入传播和基于注意力的聚合操作来编码多跳关系。

![]()

参考文献

[1] Y.-N.Chen, W. Y. Wang, and A. Rudnicky, “Jointly modeling inter-slot relations by random walk on knowledge graphs for unsupervised spoken language understanding,” in NAACL, 2015, pp. 619–629.

[2] J.Wang, Z. Wang, D. Zhang, and J. Yan, “Combining knowledge with deep convolutional neural networks for short text classification.” in IJCAI, 2017,pp. 2915–2921.

[3] H.Peng, J. Li, Q. Gong, Y. Song, Y. Ning, K. Lai, and P. S. Yu, “Fine-grained event categorization with heterogeneous graph convolutional networks,” inIJCAI, 2019, pp. 3238–3245.

[4] R.Logan, N. F. Liu, M. E. Peters, M. Gardner, and S. Singh, “Barack’s wife hillary: Using knowledge graphs for fact-aware language modeling,” in ACL,2019, pp. 5962–5971.

[5] Z.Zhang, X. Han, Z. Liu, X. Jiang, M. Sun, and Q. Liu, “ERNIE: Enhanced language representation with informative entities,” in ACL, 2019, pp. 1441–1451.

[6] B.He, D. Zhou, J. Xiao, Q. Liu, N. J. Yuan, T. Xu et al., “Integrating graph contextualized knowledge into pre-trained language models,” arXiv preprintarXiv:1912.00147, 2019.

[7] Y.Sun, S. Wang, Y. Li, S. Feng, X. Chen, H. Zhang, X. Tian, D. Zhu, H. Tian, andH. Wu, “ERNIE: Enhanced representation through knowledge integration,” arXiv preprint arXiv:1904.09223, 2019.

[8] Y.Sun, S. Wang, Y. Li, S. Feng, H. Tian, H. Wu, and H. Wang, “ERNIE 2.0: A continual pre-training framework for language understanding,” in AAAI, 2020.

[9] F.Petroni, T. Rocktaschel, S. Riedel, P. Lewis, A. Bakhtin, Y. Wu, ¨ and A.Miller, “Language models as knowledge bases?” in EMNLP-IJCNLP, 2019, pp.2463–2473.

[10] Bordes,N. Usunier, S. Chopra, and J. Weston, “Large-scale simple question answering with memory networks,” arXiv preprint arXiv:1506.02075, 2015.

[11] Z.Dai, L. Li, and W. Xu, “CFO: Conditional focused neural question answering with large-scale knowledge bases,” in ACL, vol. 1, 2016, pp. 800–810.

[12] S.He, C. Liu, K. Liu, and J. Zhao, “Generating natural answers by incorporating copying and retrieving mechanisms in sequence-to-sequence learning,” in ACL,2017, pp. 199–208.

[13] Y.Chen, L. Wu, and M. J. Zaki, “Bidirectional attentive memory networks for question answering over knowledge bases,” in NAACL, 2019, pp. 2913–2923.

[14] S.Mohammed, P. Shi, and J. Lin, “Strong baselines for simple question answering over knowledge graphs with and without neural networks,” in NAACL, 2018, pp.291–296.

[15] L.Bauer, Y. Wang, and M. Bansal, “Commonsense for generative multi-hop question answering tasks,” in EMNLP, 2018, pp. 4220– 4230.

[16] Y.Zhang, H. Dai, Z. Kozareva, A. J. Smola, and L. Song, “Variational reasoning for question answering with knowledge graph,” in AAAI, 2018, pp. 6069–6076.

[17] B.Y. Lin, X. Chen, J. Chen, and X. Ren, “KagNet: Knowledgeaware graph networks for commonsense reasoning,” in EMNLPIJCNLP, 2019, pp. 2829–2839.

[18] M.Ding, C. Zhou, Q. Chen, H. Yang, and J. Tang, “Cognitive graph for multi-hop reading comprehension at scale,” in ACL, 2019, pp. 2694–2703.

[19] F.Zhang, N. J. Yuan, D. Lian, X. Xie, and W.-Y. Ma, “Collaborative knowledge base embedding for recommender systems,” in SIGKDD, 2016, pp. 353–362.

[20] H.Wang, F. Zhang, M. Zhao, W. Li, X. Xie, and M. Guo, “Multi-task feature learning for knowledge graph enhanced recommendation,” in WWW, 2019, pp.2000–2010.

[21] X.Wang, D. Wang, C. Xu, X. He, Y. Cao, and T.-S. Chua, “Explainable reasoning over knowledge graphs for recommendation,” in AAAI, vol. 33, 2019, pp.5329–5336.

[22] Y.Xian, Z. Fu, S. Muthukrishnan, G. de Melo, and Y. Zhang, “Reinforcement knowledge graph reasoning for explainable recommendation,” in SIGIR, 2019.

[23] X.Wang, X. He, Y. Cao, M. Liu, and T.-S. Chua, “KGAT: Knowledge graph attentionnetwork for recommendation,” in SIGKDD, 2019, pp. 950–958.

如果您对文章感兴趣欢迎关注微信公众号“人工智能遇上知识图谱”,也欢迎关注同名知乎专栏“人工智能遇上知识图谱“,让我们一起学习并交流讨论人工智能与知识图谱技术。