Confluence 6 如何删除用户组图文教程

选择基本配置 选择用户组操作界面 在用户组列表中选择用户组 在界面中选择希望删除的用户组名字后面的删除按钮选项。 确定用户组删除 系统会给出提示确定用户组是否确定删除,你需要单击 Confirm 确定你对用户组的删除。 当系统对用户组删除后,会返回到用户组列表的页面,你可以在这个页面中继续对用户组进行相关操作。 https://wiki.ossez.com/index.php/Confluence_6_如何删除用户组图文教程

在博客:Python爬虫——爬取中国高校排名前100名并写入MySQL中,我们利用Python来写爬虫,将http://gaokao.xdf.cn/201702/10612921.html 中的大学排名表格爬取出来,并存入到MySQL中。

本次分享将用Java的Jsoup API来实现相同的功能,并将爬取到的数据存入到MongoDB数据库中。

我们将在Eclipse中写程序,因此,需要下载以下jar包:

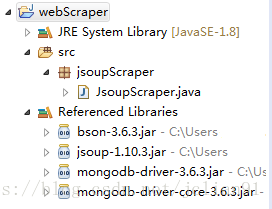

新建webScraper项目和jsoupScraper包,并将以上jar包加入到项目路径中,如下图:

在jsoupScraper包下新建JsoupScaper.java文件,其完整代码如下:

package jsoupScraper;

/* 本爬虫利用Jsoup爬取中国大学排血排行榜前100名

* 并将爬取后的结果存入到MongoDB数据库中

*/

import java.util.List;

import java.util.ArrayList;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.select.Elements;

import java.net.*;

import java.io.*;

import com.mongodb.MongoClient;

import com.mongodb.client.MongoCollection;

import com.mongodb.client.MongoDatabase;

public class JsoupScraper {

public static void main(String[] args) {

String url = "http://gaokao.xdf.cn/201702/10612921.html";

insertIntoMongoDB(url);

}

// insertIntoMongoDB()函数:将爬取的表格数据插入到MongoDB中

public static void insertIntoMongoDB(String url) {

try{

// 连接到本地的 mongodb 服务

MongoClient mongoClient = new MongoClient("localhost", 27017);

// 连接到university数据库,不过该数据库不存在,则创建university数据库

MongoDatabase mongoDatabase = mongoClient.getDatabase("university");

System.out.println("Connect to database successfully");

// 创建集合,该集合事先不存在

mongoDatabase.createCollection("rank");

System.out.println("集合创建成功");

// 将爬取的表格数据作为文档分条插入到新建的集合中

MongoCollection<org.bson.Document> collection = mongoDatabase.getCollection("rank");

System.out.println("集合 test 选择成功");

List<String> content = getContent(url);

for(int i=2; i<content.size(); i++) {

String[] record = content.get(i).split(" ");

org.bson.Document document = new org.bson.Document("rank", record[0]).

append("name", record[1]).

append("province", record[2]).

append("local_rank",record[3]).

append("score", record[4]).

append("type", record[5]).

append("stars", record[6]).

append("level", record[7]);

List<org.bson.Document> documents = new ArrayList<org.bson.Document>();

documents.add(document);

collection.insertMany(documents);

System.out.println("第"+i+"条文档插入成功");

}

// 关闭mongodb连接

mongoClient.close();

System.out.println("MongoDB连接已关闭");

}

catch(Exception e){

e.printStackTrace();

}

}

// getContent()函数,返回爬取的表格数据

public static List<String> getContent(String url){

List<String> content = new ArrayList<String>();

// 利用URL解析网址

URL urlObj = null;

try{

urlObj = new URL(url);

}

catch(MalformedURLException e){

System.out.println("The url was malformed!");

return content;

}

// URL连接

URLConnection urlCon = null;

try{

// 打开URL连接

urlCon = urlObj.openConnection();

// 将HTML内容解析成UTF-8格式

Document doc = Jsoup.parse(urlCon.getInputStream(), "utf-8", url);

// 刷选需要的网页内容

Elements elems = doc.getElementsByTag("tbody").first().children();

// 提取每个字段的文字部分

content = elems.eachText();

return content;

}

catch(IOException e){

System.out.println("There was an error connecting to the URL");

return content;

}

}

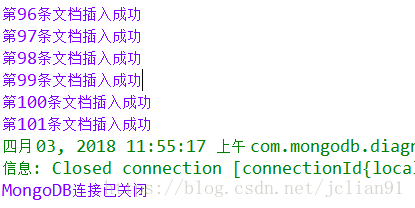

} 运行上述程序,结果如下:

该爬虫其实并不复杂,实现的原理也很简单,我们已经用能Java和Python来实现了。希望以后能写一些关于Java爬虫的文章,欢迎大家交流~~

微信关注我们

转载内容版权归作者及来源网站所有!

低调大师中文资讯倾力打造互联网数据资讯、行业资源、电子商务、移动互联网、网络营销平台。持续更新报道IT业界、互联网、市场资讯、驱动更新,是最及时权威的产业资讯及硬件资讯报道平台。

近一个月的开发和优化,本站点的第一个app全新上线。该app采用极致压缩,本体才4.36MB。系统里面做了大量数据访问、缓存优化。方便用户在手机上查看文章。后续会推出HarmonyOS的适配版本。

马里奥是站在游戏界顶峰的超人气多面角色。马里奥靠吃蘑菇成长,特征是大鼻子、头戴帽子、身穿背带裤,还留着胡子。与他的双胞胎兄弟路易基一起,长年担任任天堂的招牌角色。

Spring框架(Spring Framework)是由Rod Johnson于2002年提出的开源Java企业级应用框架,旨在通过使用JavaBean替代传统EJB实现方式降低企业级编程开发的复杂性。该框架基于简单性、可测试性和松耦合性设计理念,提供核心容器、应用上下文、数据访问集成等模块,支持整合Hibernate、Struts等第三方框架,其适用范围不仅限于服务器端开发,绝大多数Java应用均可从中受益。

Sublime Text具有漂亮的用户界面和强大的功能,例如代码缩略图,Python的插件,代码段等。还可自定义键绑定,菜单和工具栏。Sublime Text 的主要功能包括:拼写检查,书签,完整的 Python API , Goto 功能,即时项目切换,多选择,多窗口等等。Sublime Text 是一个跨平台的编辑器,同时支持Windows、Linux、Mac OS X等操作系统。